Prologo: La ultima presentación de modelo de lenguaje de OpenAI es GPT-4 situado cronológicamente en el 2023, crea unas nuevas posibilidades y abre multitud de campos a la inteligencia artificial iA.

Que es GPT-4 de Open-AI

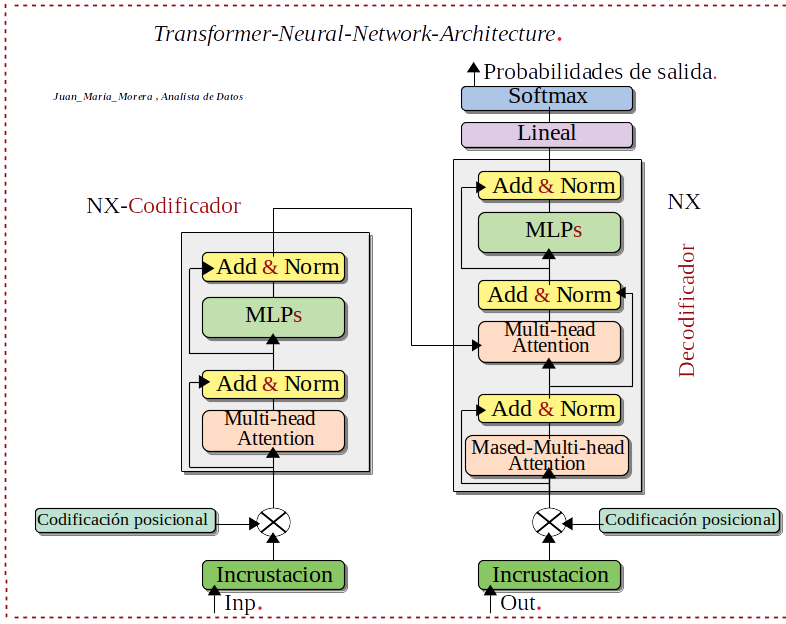

-. GPT-4 Generative pre-trained transformers (GPT) el cuatro es la versión, creado por OpenAI, es un modelo de lenguaje grande multimodal LLM y basados en la arquitectura de transformers, están previamente entrenados en grandes conjuntos de datos de texto sin etiquetar para predecir el siguiente token. Se usa la técnica Self-supervised learning y son capaces de generar contenido similares a los humano. Este modelo GPT-4 es la base para modelos optimizados a través de una API con diferentes servicios como Chatbot, ChatGTP,etc. Referente a los token son representaciones numéricas, cada token se convierte en un vector, en una tabla de incrustación de palabras.

Aclaremos algunos conceptos:

- .Que es LLM: Un Large-Language-Model o LLM, conocido también como modelo de lenguaje de gran tamaño, este modelo de lenguaje se compone de una Network-Neuronal con muchos muchos parámetros y un entrenamientos de grades cantidades de datos. Estos datos están sin etiquetar, entrenamiento mediante Aprendizaje-Autosupervisado.

- .Que es el Aprendizaje auto-supervisado: Self-supervised learning, Nos encontramos con una técnica donde los datos de de entrenamiento se auto-etiquetan de forma autónoma una parte de la entrada de la Network-Neuronal, se usa como supervisión para predecir la parte restante del Input de la Network-Neuronal.

- .Que es API: interfaz de programación de aplicaciones, Permite la conexión entre distintos sistemas, aplicaciones. Comparte información y funcionalidades permite que una aplicación se comunique con otra y soliciten datos o acciones concretas.

Antecedentes

-. GPT-4 este es el modelo de lenguaje mas grade y complejo con fecha de lanzamiento en 2023, creado por OpenAI. Los antecedentes comienza 2018 se introdujo el primer modelo GPT-1, desde 2018 a 2023 tenemos las diferentes versiones para llegar a GPT-4, dando un salto en el enfoque cualitativa y cuantitativa a la recopilación de datos y rumores de 100billones de parámetros ¡no comfirmado por OpenAI y desmentido por el CEO! Pero no dan el dato ¿estoy pensando preguntar a GTP-4?.

-. Generative pre-trained transformers GPT significa, transformador preentrenado generativo, en este modelo podemos profundizar en los antecedentes analizando el nombre GPT-4, comentado anteriormente la P– (preentrenando) pasemos a comentar G-(generativo) ; Network-Neuronal-Generativas se crearon para generar textos y conversaciones realistas.

Conceptos-Importantes

-. Usa la Arquitectura-red-neuronal de los Transformers. Los Transformers están reemplazando en determinadas ocasiones a las Network-Neuronal convolucionales y recurrentes. Otro asunto importante por afectar el rendimiento del modelo de inteligencia artificial iA son los MoEs que básicamente convierte la Inteligencia-Artificial-iA en subredes especializadas, llamadas Experts se activa según la consulta que hagamos y por ultimo como tema importante; la Ventanas-Contexto-iA es la cantidad de información que recuerda la Inteligencia-Artificial-iA en un momento dado y se mide en Tokens.

Aclaremos estos Conceptos:

- .Que son los Transformers: Arquitectura-red-neuronal, Los transformers son un tipo de arquitectura de Network-Neuronal que transforma o cambia una secuencia de entrada en una secuencia de salida. ¡Como hace esto! Aprendiendo del contexto y rastrean las relaciones entre los componentes de la secuencia. Los Transformers están reemplazando en determinadas ocasiones a las Network-Neuronal convolucionales y recurrentes.

- .Qué son los tokens: unidad de testo del modelo, Los tokens son grupos de caracteres que representan la unidad fundamental del texto. Generados por un algoritmo tokenizador, puede ser una palabra pero tiene en cuenta todos los caracteres, hasta los emojis, esto depende del idioma, del modelo utilizado, etc. La proporción adecuada a considerar: (En Inglés: una palabra mas o menos 1.3 tokens) . (En Español: una palabra más o menos 2 tokens).

- .Qué son los MoEs: Mixture of experts, Esta técnica de Machine-Learning que divide un modelo de Inteligencia-Artificial-iA en subredes separadas, llamada expertos. Estos Sistemas-Expertos se ejecutan uno a unos-pocos para cada entrada. Esta arquitectura de Experts permite la reducción de costes de calculo durante el entrenamiento y se consigue rendimientos mas altos durante la Inferencia. Se activa selectivamente los Sistemas-Expertos necesarios para la tarea, en lugar de todo el modelo de Inteligencia-Artificial-iA.

- .Que son las Ventanas-Contexto-iA: es el texto que la iA puede leer y lo recuerda durante la sesión. El tamaño de la Ventanas-Contexto-iA, es el tamaño asimilado por la iA, este texto se mide en Tokens. Porgamos algún ejemplo de la versión mas básica: GPT-4-estándar 8000-tokens, del modelo Gemini-1.5 de Google 128000-tokens y Llama-3 de 8.192-tokens Estos datos se sitúan cronológicamente a principio del 2024.

- .Que son Entrenamiento & Inferencia: los modelos-iA lo primero es Entrenarlos ¡con que! con una gran cantidad de datos de todo tipo, de estos extraemos tendencias, parámetros, etc Tenemos un modelos-iA-preentrenada aplicaremos tareas específicas, mediante Inferencia estas Inferencia es el proceso por el cual se derivan conclusiones a partir de premisas o hipótesis iniciales.

Acceso

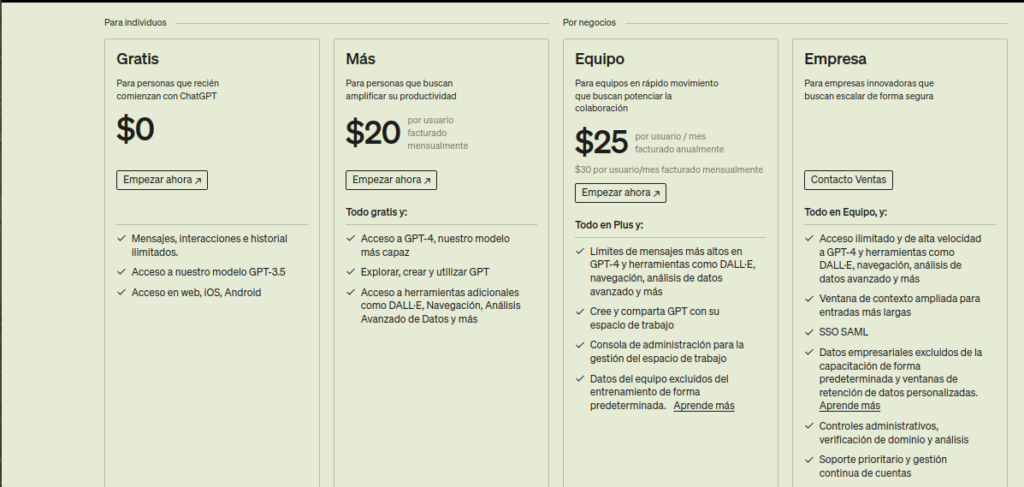

-. Como podemos acceder a GPT-4 por su sitio-Web https://openai.com/gpt-4 nos proporciona dos opciones de probar Chat-GTP y Chat-GTP las dos nos solicitan crear una cuenta.

-. Por otra parte en el menú Chat-GTP/Precios

-. Tenemos una opción gratis pero no es GTP-4 sino GTP-3.5 si queremos acceder a GPT-4 tenemos que pasar por caja.

Recopilando:

Este post no intenta dar una visión comercial de GTP-4 que posibilidades nos prometen y sus tendencias, sino una visión mas de origen de donde viene como el Hardware que necesita, el entrenamiento muy importante etc.